Cette semaine, nous sommes ravis d’échanger avec Augustin Marty, CEO de Deepomatic. Il s’agit d’un éditeur de logiciel spécialisé dans la reconnaissance d’images. Comment la computer vision nous accompagne dans nos tâches quotidiennes ? Découvrez en plus ici !

Racontez-nous l’histoire de Deepomatic

Deepomatic est une société issue d’une entreprise appelée Smile, qui était un moteur de recherche par l’image. Concrètement, c’est un moteur qui permet de faire le lien entre une image inspirante (publicité dans la rue, magazine, photo sur les réseaux sociaux) et un produit dans le e-commerce.

Par la suite, nous avons très vite implémenté des outils permettant de créer facilement et rapidement des algorithmes précis de reconnaissance d’images. Ces outils nous ont permis de rentrer dans la deuxième phase de la vie de Deepomatic, et de développer très rapidement notre deuxième business model plus orienté business to business et grands comptes. Nous avons packagé les outils sur une plateforme unique low code à destination des professionnels pour réaliser et maintenir les projets de reconnaissance d’images.

Nous avons conceptualisé la plateforme il y a cinq ans, et nous nous disions à l’époque qu’il manquait un outil dédié aux gens du métier qui permettent de construire des applications de reconnaissance d’images pour rendre autonomes nos clients qui industrialisent des projets de reconnaissance d’images. Nous avons désormais 13 clients en production qui développent environ 8 cas d’usage différents.

Notre proposition de valeur est la suivante : rendre nos clients capables de maintenir leurs applications de reconnaissance d’images, de faire évoluer leurs IA pour de la mise en production à très grande échelle. Nous travaillons aujourd’hui avec Suez sur de la reconnaissance de déchets dans le monde, avec Sanofi, ou encore avec Peugeot sur le développement de fonctionnalités d’aide à la conduite. La plateforme Deepomatic a permis aux utilisateurs de prendre en main l’applicatif et de faire évoluer l’IA en fonction des besoins du client.

À partir de ce moment-là, nous avons décidé de faire des choix sur la typologie des cas d’usage que nous souhaitions proposer pour mieux accompagner les clients dans toutes les dimensions transformatives des projets en parlant leur langage.

Entre mettre une application en production et en faire l’outil de prédilection dans le groupe, il y a un passage au niveau de maturité qui exigeait que nous comprenions les enjeux de nos clients. Nous nous sommes intéressés uniquement aux cas d’usage que nous traitions déjà et que j’illustrerai plus tard.

Qu’est-ce que la Computer Vision ? Comment cela fonctionne concrètement ?

outil basé sur l’IA capable de reconnaître une image, de la comprendre, et de traiter les informations qui en découlent.

Pour beaucoup, la vision par ordinateur est l’équivalent, en termes d’IA, des yeux humains et de la capacité de notre cerveau à traiter et analyser les images perçues. La reproduction de la vision humaine par des ordinateurs constitue d’ailleurs l’un des grands objectifs de la computer vision.”

La computer vision est basée sur l’apprentissage par l’exemple (deep learning).

Si nous prenons le cas de détection de dégât de pare-brise de véhicule, la reconnaissance d’images se fait en deux étapes, en effet, le but de l’IA n’est pas seulement d’être capable de détecter le dégât, mais bien d’en tirer une information compte tenu du contexte et donc une solution.

La première étape de l’apprentissage consiste à donner les coordonnées du dégât dans l’image. Pour cela, il a fallu avoir éduqué au préalable les réseaux de neurones de détection au travers d’exemples jusqu’à ce qu’ils aient compris l’information. Donc pendant la phase de paramétrage, il faut montrer à l’ordinateur où est le dégât. Ensuite il y a des règles de contexte (avant, arrière, latéral, etc). Enfin, il y a un ensemble de règles métiers (selon le pays, la région) qui permettent à l’IA d’en déduire des solutions adaptées.

Lors de la deuxième étape, l’IA doit être capable de diagnostiquer le type de dégât. C’est seulement après avoir reçu toutes les informations citées précédemment que l’IA peut être en mesure de déterminer la solution au problème (règles nationales, contexte, paramétrage…). La réussite de Deepomatic dépend de sa bonne intégration dans le système d’informations du client et de la bonne maîtrise de l’ensemble de la chaîne de vie de la donnée.

Qu’est-ce qu’un technicien augmenté ?

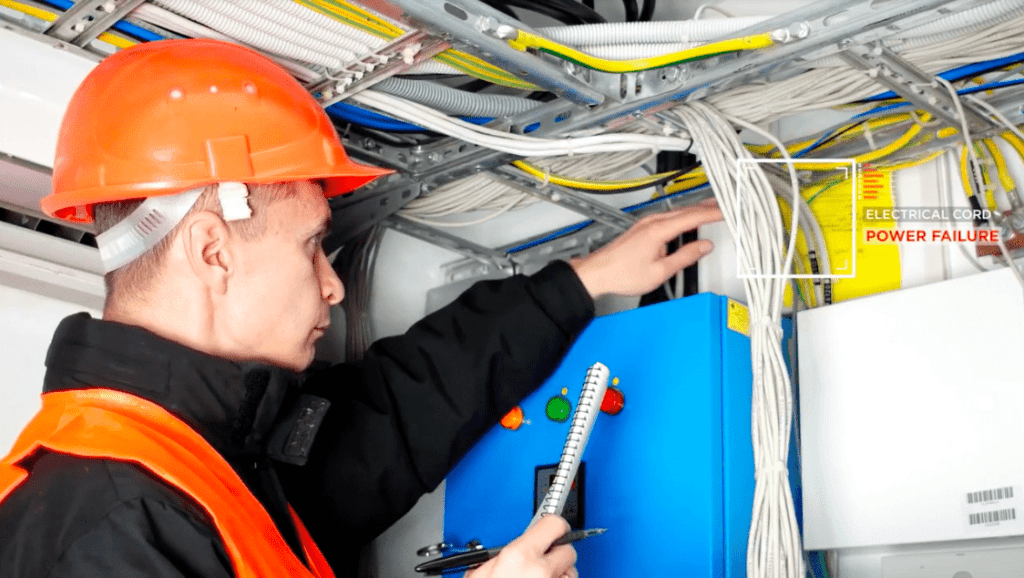

Comme je l’ai expliqué précédemment, nous avons fait des choix sur les cas d’usage que nous proposons à nos clients. Nous nous sommes donc intéressés aux “field services”. Ce sont des services qui amènent des techniciens et des ingénieurs à parcourir le monde (réseaux d’eau, réseaux d’électricité…) pour effectuer des interventions techniques sur le terrain. Dans ce cadre, la reconnaissance d’images a la possibilité de les aider dans leurs tâches quotidiennes.

Nous avons assez vite compris qu’il y avait un point commun à tous les cas d’usage que nous adressons : un diagnostic peut être fait à partir d’une situation que nous prenons en photo. Grâce à l’IA, le diagnostic est instantané et fiabilisé.

Dans le secteur des télécoms, il y a un cas d’application extrêmement concret. En effet, beaucoup de particuliers rencontrent des problèmes lors du raccordement du matériel à la fibre optique. Dans le secteur industriel, il y a un défaut de production parmi des milliers, voire millions d’articles produits. A contrario, dans le monde des opérations sur le terrain, les opérations sont plus fluctuantes avec des chaînes de sous-traitance qui impliquent des taux d’échecs gigantesques. Typiquement, dans les télécoms beaucoup d’interventions ne vont pas au bout.

Notre objectif est donc d’aider le technicien à réussir son intervention du premier coup. Pour cela, il prend en photo son intervention sur 5 à 10 moments clés, et il va être en capacité de recevoir un retour en temps réel, être capable de corriger le tir instantanément si nécessaire et donc réussir son intervention.

Par ailleurs, le fait que le contrôle qualité, avant a posteriori, soit fait sur le moment de l’intervention, permet de systématiser l’intervention, et d’exercer une meilleure maîtrise de la qualité. Ce cas d’usage étant très répandu et central pour un certain nombre de sociétés de services, nous avons fait le choix de nous concentrer sur cette problématique.

Comment simplifier le quotidien des Data scientists lorsqu'ils travaillent sur des sujets d'IA ?

En fait, Deepomatic est une source d’informations additionnelle extrêmement précieuse pour la data science. C’est une plateforme efficace pour traiter l’image et la vidéo du terrain pour en extraire des informations précises.

Si je prends l’exemple de la SNCF, les rails représentent un asset et constituent un réseau. Aujourd’hui, les trains sont dotés de caméras et lorsqu’ils passent sur les rails, nous sommes en mesure de visualiser l’état des rails et de dresser une cartographie de l’état d’usure de ces rails. Il est également possible d’entrevoir les endroits où les rails se dégradent plus rapidement et donc d’agir de manière préventive.

Ces contenus images et vidéos vont en somme multiplier la quantité d’informations disponibles aux Data Scientists, plus rapidement. Et nous travaillons de concert avec les Data Scientists pour résoudre des problèmes concrets.

Deepomatic est aussi un outil qui permet d’itérer facilement sur son dataset avec des modèles fixes. C’est en effet l’un des pain points souvent retrouvés chez les Data Scientists. Grâce à Deepomatic, les data scientists sont en mesure d’optimiser leurs datasets facilement.

D’après vous la reconnaissance d’image peut s’appliquer à d’autres domaines, lesquels ? et d’ici 2030 comment voyez-vous évoluer ce secteur ?

Mon pari, c’est de dire qu’aujourd’hui, les cas d’application que nous voyons de manière générale sont évidents. Je pense évidemment au contrôle qualité dans les usines, à l’identification des personnes (smartphones, site web…), à la reconnaissance faciale anti-terroriste, aux véhicules autonomes… Certains cas dont nous entendons parler ne sont pas encore une réalité aujourd’hui. En effet, nous sommes actuellement dans une phase de simplification des problèmes quotidiens, une phase d’automatisation des tâches simples. Mais d’ici à 2030, peut-être que certaines promesses seront tenues.

Aujourd’hui, on remarque qu’il n’y a pas qu’un cas d’application, il y en a déjà des milliers. En revanche, seuls très peu de cas sont réellement en production. Par exemple, en médecine, nous sommes déjà confrontés à une infinité de possibilités. La contrainte est qu’il faut une précision quasi absolue pour apporter une réelle assistance aux médecins. Il faut travailler énormément sur un cas très précis pour arriver à apporter un diagnostic précis et automatisé. D’ici à 2030, nous allons décomposer les grands champs d’application cités plus haut (capacité de déplacement des robots, contrôle qualité, compréhension des comportements).

De plus, nous pouvons prévoir l’arrivée d’une quantité faramineuse de petites applications qui vont nous simplifier la vie, car justement, les coûts de production auront diminué. Nous le voyons déjà à notre échelle, notamment dans l’agriculture de précision par exemple.

Aujourd’hui, le constat est que la reconnaissance d’image n’est pas assez démocratisée et encore trop onéreuse pour que l’on puisse exécuter les milliers de cas déjà identifiés. La clé selon moi, c’est d’apprivoiser cette technologie, à travers des outils comme Deepomatic justement, pour faire baisser les coûts de production et permettre le déploiement à grande échelle. Ainsi, le ROI de la mise en production de ces projets augmentera d’autant. Nous aurons également une meilleure compréhension de l’intégration de ces projets, de façon à ce que les bénéfices opérationnels soient tangibles et actionnés.

La reconnaissance d’image pose des questions éthiques non négligeables, comment Deepomatic s’inscrit dans cette vision ?

Chez Deepomatic, nous avons fait le choix de traiter les milliers de cas d’applications qui n’étaient pas vraiment concernés par les questions éthiques. Les cas d’usages les plus visés par les questions d’éthique sont la reconnaissance faciale et les véhicules autonomes. Si vous ne traitez pas ces sujets, alors vous avez moins de probabilité d’être confrontés à ces questions. Notre mission est d’accompagner le technicien dans ses tâches quotidiennes. Il y a toujours des risques quant à savoir comment implémenter cette technologie pour ne pas le sanctionner. Néanmoins, nous avons deux grands chevaux de bataille d’un point de vue RSE.

Premièrement, certains sujets d’éthique qui nous intéressent particulièrement sont les sujets d’optimisation qui engendrent une transformation de l’emploi. Nous faisons partie d’un processus de mondialisation important qui peut être violent en temps de crise, et il faut savoir accompagner ces changements pour qu’ils soient les plus fluides possible.

Deuxièmement, un autre sujet qui nous concerne particulièrement est l’impact environnemental de l’intelligence artificielle. La question est de savoir comment on minimise cet impact. Aujourd’hui, nous avons la capacité de connaître très la quantité de CO2 que nous générons. Nous avons créé un modèle très précis en ce sens. Par ailleurs, nous avons contribué à absorber autant de CO2 que ce que nous avons émis de façon à être neutre en carbone. Nous sommes également capables de communiquer l’impact environnemental de la plupart de nos cas d’usage à nos clients.

Que dire des risques liés à la reconnaissance faciale ?

Personnellement, je trouve que ces technologies font très peur, je n’ai pas envie que l’on sache où je suis en permanence. Il faut absolument avoir une réflexion profonde sur le sujet. Ces technologies sont très puissantes et peuvent être utilisées à des fins toxiques qui vont à l’encontre des principes démocratiques, de liberté que nous connaissons aujourd’hui. Et c’est en partie pour cela que nous avons fait le choix de nous tourner vers les applications civiles.

PDG et président de Deepomatic, Augustin Marty a étudié l’économie à l’École des Ponts à Paris et à l’UC Berkeley. Il a lancé une société de tablettes informatiques en Chine, avant de rejoindre le groupe de construction industrielle Vinci, en tant qu’ingénieur commercial pendant deux ans.

Augustin conduit la vision de Deepomatic de transformer le déploiement de la vision par ordinateur, en restant concentré sur la création de valeur pour nos clients et le timing de la mise sur le marché. Capitalisant sur son expérience chez Vinci, Augustin comprend les enjeux des grands groupes industriels et la complexité de leur processus de décision.